全球精明到莫得,Qwen3这一组模子被称作「混杂推理模子」。

啥是混杂推理模子?

混杂推理模子的中枢想想是:像东谈主类相同纯真地处理问题,既能「快速反应」处分浅易任务,也能「慢工出细活」长远分析复杂问题。

这种设想让推理模子不再“一根筋”,不错把柄任务需求纯泄露换想考模式↓

1. 快想考模式

濒临浅易问题,AI只需要快速调用已有知识库,给出即时谜底,比如翻译句子、回应一般学问。

既裁汰用户恭候手艺,又从简推理支拨。用户省了tokens,模子运营方省了算力。

2. 慢想考模式

濒临复杂问题,AI会像东谈主类相同「打草稿」,一步步拆解复杂问题,比如解数学题、写代码、制定策略狡计、星盘命瓦解读等等。

是以你要知谈喽,大模子算命很销耗算力(tokens)哦

混杂推理模子把这两种能力调节到一个系统里,既不会让AI在浅易问题上「过度纠结」虚耗资源,也不会让它在贫困前「松懈下论断」导致失实。

举个例子,全球打游戏刷怪,传统“一根筋”推理模子无论遇见杂兵小怪还是BOSS,齐一律放大招,威力大然则很快就没蓝了。

而混杂推理模子就不相同,懂得看东谈主下菜单。

遇见小怪就平A,遇见BOSS才开大,这么就能省蓝。

怎样达成双模式切换?

以当今公开的混杂推理模子(如Qwen3、 Claude 3.7)为例,其切换的花式有两种:

1. 算法识别:淹没模子内的智能分派

通过格外算法设想,让模子里面自动识别任务复杂度。

浅易问题 → 径直调用浅层采集模块,快速输出效果

复杂问题 → 激活深层推祈望维链,冉冉拆解问题并考据中间才气

2. 显式落幕:用户主动选择想考进程

用户可通过提醒(如“请详备分析”或“快速回应”)手动切换模式。

快速模式:访佛凡俗聊天机器东谈主的即时反应

深想模式:AI会涌现「想维经由」,举例列出推导公式、代码调试才气

以刚刚上线的Qwen3为例,用户不错通过页面上开关来切换模式,AG百家乐感觉被追杀况且还不错诞生想考预算,幸免过多的Tokens销耗。

(注:DeepSeek官方界面关闭深度想考时,模子会切换到v3模子,实质上是R1和V3两个模子轮流处事)

回顾阿里QwQ刚上线的时候,曾被东谈主吐槽想维链太长,“过度想考”,这一版,Qwen3就来了一个大大的改造。

这种花式无需突出考研两个独处模子,用户也无需部署两个独处模子,从简拓荒本钱和部署本钱。

混杂推理有啥实用价值?

1. 算力篡改:能省太多钱

传统“一根筋”深度推理模子需要销耗大批算力,而混杂模子能按需分派资源,责问部署门槛。

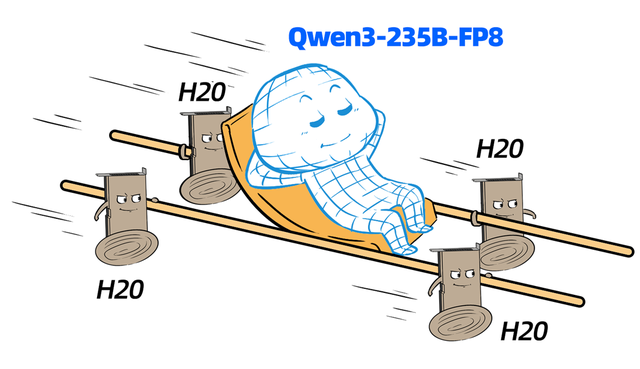

比如Qwen3仅需4张H20显卡(96G版块)即可部署齐全版(235B-FP8版块)。

同期,混杂推理模子把柄问题难易来选择想考的模式,并不错动态诞生想考深度。

当大模子想考不错量(tokens)预算而行,不仅训诲了AI实用性,也减少了无须要的算力虚耗。

2. 能力跃迁:鱼和熊掌可兼得

畴昔大模子要么擅长快速反应(如Meta Llama系列),要么专精复杂推理(如OpenAI o1),但难以兼顾。

混杂模子初次达成了两者和会,一个模子既会“平A”输出也能“放大招”,落地打怪的场景就会愈加丰富。

膨胀阅读:

本文所讲仅仅狭义「混杂推理模子」,广义上讲,以下也算「混杂推理模子」。

1、模子混杂:一个小模子处理旧例问题,一个大模子处理复杂问题。

2、硬件混杂:用异构算力来同期完成推理,比如CPU+GPU+NPU协同推理。

3、精度混杂:部分推理用FP16,部分用INT8(先混杂精度量化,再混杂精度推理,这种尤其顺应当下许多国产卡不支撑FP8的情况)

4、算法混杂:加入RAG,先检索后推理。

不管奈何混ag百家乐假不假,想法齐是为了提高速率、责问本钱、训诲纯真性。